ドミニク・チェン プレゼンテーション 生態映像メディアを巡る創造性

■夢と偏在化する映像コンテンツ

ドミニク

さて、今日は映像というテーマをいただいていますが、最近は映像の仕事をしておらず、ソフトウェアを制作したり、プロジェクトを動かすようなことばかりしている。ですので、あまりじっくり考えることがなかったのですが、ちょうどこの夏に映像情報メディア学会創立60周年を記念する学会誌で「映像情報メディアの未来ヴィジョン」という特集がありました。そこで想像力を膨らませて好きなように書いてくれという注文を受けて書いた論文「胡蝶の夢──生態映像メディアを巡る創造性」があるのですが、ここで書いた問題を話のイントロにしたいと思います。

ひとつは夢の話です。個人的な話になりますが、僕は夢をほぼ毎日見ます。10分昼寝しても見る。夢の学問では、明晰夢(Lucid Dream)というものがあります。夢のなかで、夢を見ているという自覚を持ちつつ夢を見続ける経験のことですが、これは訓練でできるようになります。訓練方法はすごく簡単で、枕の横にメモ帳を置いておいて、その日見た夢をスケッチでも何でもいいから書きなぐっておく。そうすると、印象の強い夢なんかは、あたかも実世界で経験したかのように、10年でも20年でも覚えておくことができるようになる。夢を記憶する訓練を続けていくと、明晰夢が比較的見やすくなります。この訓練を続けていると、だんだん自分の能力も上がってきて、最近は夢のなかで時間を逆行させることに成功しました。夢のなかで東京の交差点を運転していて、その交差点を左折すると、後ろから来たパトカーになぜか捕まった。じゃあ時間を巻き戻してしまおうと思って、巻き戻しモードを発動させたら時間が戻っていって、今度は右折して警察に捕まらなかったという夢です(笑)。

そうした夢の操作可能性がすごく面白くて、夢に関する論考を書きました。もうひとつだけ前振りをすると、僕も結構ギブソニアンだと思っていますが、個人的には直接知覚という概念を最も直接知覚するときが、夢を見始める瞬間です。先ほどサーバーの話をしましたが、ネットワークの世界にはレイテンシー(Latency)という言葉があります。これは観察者である自分と、応答を図ろうとしている対象とのネットワーク上の距離のことです。これには物理的な距離と帯域速度がかかわってきます。光回線のほうがもちろん早い。例えば私は今皆さんの映像を見ているわけですが、その映像よりも、夢を見ているときのレイテンシーのほうが、夢の発信地と受信地が同じですからより0に近く、短いと言えます。今見ている映像は光の速度の遅延を考えると過去を見ていることになりますし、それに加えて、いろいろな受容機関を経て、意識的にせよ無意識的にせよ、いろいろな意味を付加したりして、環境的な情報を抽出している。夢を見ているときの生々しい知覚は、そうしたフィルタリングをほぼ介さずに見ているのではないか。今僕が話している夢の映像は、まだメディア化されていない映像ですので、自然言語に頼ってこのようにお話するしかないのですが、それをメディア化できる将来というものを仮定し、そこから主体の問題や創造性の境界線の問題を、逆に将来から現在に向けて照射することをやってみたいと思いました。

先ほどから、虚と実の決定不可能性の話が挙がっています。僕の場合は、知覚において脳とのレイテンシーが極限的に小さい夢という現象がひとつの足がかりになるように思っています。低解像度のほうが体験深度が深く、榑沼さんの言葉でいうと所作や情動の誘発力が高いと思いますが、そこには相互作用度みたいなものも考えられるのではないでしょうか。今日繰り返し問われているテーマが、榑沼さんの話では自己と対象との距離の撹乱であり、平倉さんの話では生成変化は果たして可能なのかということです。僕はそのことを、カップリングというサイバネティックな言葉で考えています。

このあいだ、フランシス・F・コッポラ監督の『コッポラの胡蝶の夢』(2007)という映画を観ました。その主人公は名前がドミニクという言語学者で、それだけでもう観に行ったのですが、本当に悪い夢をそのまま映画化したような作品で、映画としてはあまり感心しませんでした。ただ、蝶の夢を自分が見ている、つまり実が自分という人間身体で、蝶という夢想が虚なのか、あるいは今動いている自分が蝶の見る夢なのか、ということの決定不可能性の話ではありました。それを伏線に置いておきます。どうしてそれを考えているかというと、僕はインターネットを主な活動の場としていて、最近は映像コンテンツを扱うサービスを自分でやっているわけではないので、あくまで観察者なのですが、ひとつ確実に言えるであろうことは、映像コンテンツが偏在化しているということです。iPhoneのような高機能なデヴァイスでなくても、多くの3G携帯には動画機能がついています。Twitterの話が今日は出てきましたが、Twitter以外にもクローンサービスが無数にあって、ミニブログと総称されています。そういった、ブログほどコミットメントがなくても、簡単に発言ができるということが、テクスト、動画、画像と、どんどんマルチモーダル化している状況がある。

一方で、リード(読み)/ライト(書き)・ウェブという言葉がある。ウェブ2.0と言ったほうがみなさんもご案内かと思います。それまでのウェブは主に、大多数の人が読み込むだけで、情報を作るのはあくまでプロフェッショナルだったのですが、それに対してリード/ライト、つまり読めるし書き込めるというモデルが4年ほど前から出てきました。ティム・オライリーがウェブ2.0という言葉を出してからだと思います。コンテンツというものが、ただアクセスされるだけではなくて、アクセスする主体につねに編集される、編集されつつどんどん変化していく。そういう文化をクリエイティブ・コモンズの周りでは「リミックス文化」と呼んでいます。そうしたコンテンツがどんどん偏在していって、コンテンツを作り出すデヴァイスがどんどん小型化を続けていますが、その究極にはライフログ (Lifelog)という考え方があります。これは、人間の一生の視覚情報をすべて記録し続けても、容量の大きなハードディスク数個分に収まってしまう計算が成り立つので、それではその情報をどのようにインデックス化して、人間の生活にフィードバックさせるかということを研究する領域です。そうした研究領域がありつつ、昨今ではブレインコンピューター・インターフェイスというものもあって、人間の脳とコンピューターを接続するインターフェイスの研究も進められています。そうした研究によってその2つが交差する可能性が明らかにされているので、そこを足がかりにしてありうる未来について考えていきたいと思います。

■ Type Traceからライフ・ログへ

この話に入る前に、そこに重なってくる自分の活動を紹介します。Type Traceというソフトウェアを3年くらい前から開発していまして、これはキーボードで叩いたテクスト生成の流れを、時間軸上で動画のように記録して再生することができるものです。それを人に送って再生することもできる。作家の舞城王太郎さんとコラボレーションさせていただく機会を、こちらの写真美術館でいただきまして(「文学の触覚展」2007年12月15日〜2008年2月17日)、舞城さんには新作小説を書いていただきました。自動ピアノ的なキーボードも同時に作成しました。スクリーンに映っているのが舞城さんの叩いたキーボード記録の再生です[fig.17]。

2カ月のあいだ、舞城さんが世界のどこかで新作を書いていて、彼がアップロードボタンを押すと会場にダウンロードされて、そこにいる観客がそれを見ることができるという展示でした。そこで印象深かったのが、おそらく熱狂的な舞城さんのファンと思われる方が、4時間くらいスクリーンに張り付いて、神の降臨を待つかのように凝視していた。そこで気がついたのですが、スクリーンを見ていると、今そのテクストの生成している場所に書き手が居るという錯覚、つまり書き手の同一性が認知上で発生してしまうということです。有名な作家さんだからこれが作動させやすい、ということもあると思いますが、例えば友人や恋人や家族から送られてくるテクストにも、同じくらい存在を伝えることができるのではないかと考えて、このソフトのウェブ・ヴァージョンを開発していました。いろいろなヴァージョンがあって、例えばmixiの日記、Gmail、Twitter、あるいは中田英寿がこれで日記を書いたらどうなるかと、いろいろ実験していました。先ほど虚と実が簡単に入れ替えられてしまうことを話しましたが、こうして文字が動き出すことだけでも決定不可能性が発動するという経験をしました。このType Traceの情報もライフログ的な意味合いを持ちえて、いつ、どのように、どのような言葉を叩いたのかが記録される。重要なのは、どのような言葉をその人がデリートしたのかまでも可視化され、人に見られることです。これがその人の思考の経路を表わしている。書いては消し書いては消しする人もいれば、いきなり書き出して一度も校正せずに書き終える人もいます。今のメールでは、結果だけしか見られず、そこでは時間軸は消去されていますよね。もちろんすべてのメールをType Traceで見ていたら日が暮れてしまうのですが、そこをうまく解析して新しい情報を抽出することは可能だと思っています。

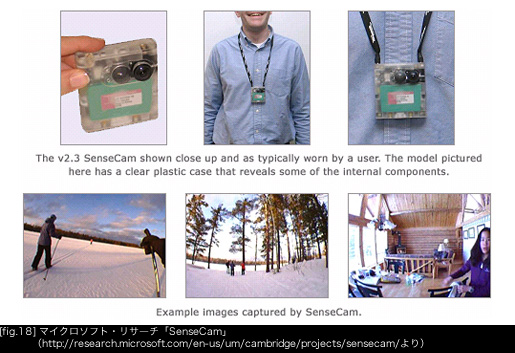

もう一度概観的な話に戻ります。ライフログには、例えば有名なものではマイクロソフト・リサーチの「SenseCam」があります[fig.18]。

首から下げているだけで自分の目の前にあるものをひたすら撮り続けて、一生分の画像が数ペタバイトのストレージに記録されるというものです。またウェブの世界では、Googleが打ち立てて成功している「OpenSocial」という標準規格があります。異なる会社、異なる企業同士、あるいは異なるコミュニティや異なるサービス同士でも、ソーシャルネットワークの標準形を決めることで繋がることができる。そうするとユーザーにも開発者にも利するところが多いというものです。最近のmixiのオープン化は、このOpenSocialに沿って行なわれているわけです。もうひとつ、DataPortabilityという非営利団体がある。Googleの「OpenSocial」と同じように、データ自体の移植可能性、つまり異なるサービス同士でも通信できるように情報を設計するということをやっています。例えばFacebookとmixiとのあいだで情報を交換できるようにする。囲い込みを行なって閉鎖的に領土を固めるのではなくて、むしろ交通をうまく設計して、どちらがよりオープンになりうるかの戦争がウェブでは起きていて、GoogleとFacebookが争っています。またほかにも、ライフログの未来形を感じさせるひとつのサービスがあります。Googloの創業者の奥さんが最近作った23 and Meという会社です。23は染色体の数なのですが、自分の尿のサンプルをこの会社に送ると、1週間くらいで自分の数万年にわたる先祖がどこからきたのかを示すヒートマップを作ってくれたり、どの遺伝的な病気の発症確率を持っているのかを洗い出してくれるというサービスをしています。ライフログもここまできたかという感じがします。ほかにも事例はたくさんあるのですが、大局的な紹介だけさせていただきました。